LangGraph框架概览

1、LangGraph简介

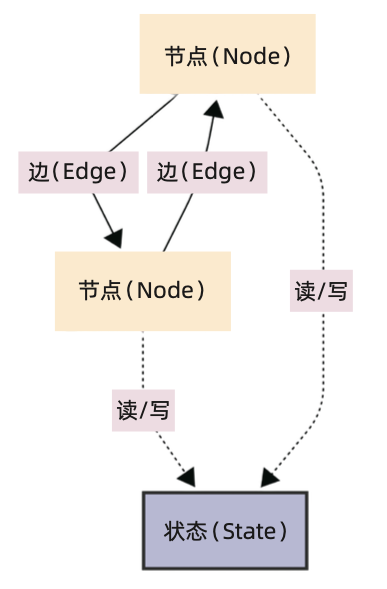

与传统的线性流程或树状结构截然不同,LangGraph 采用了状态图结构来设计 AI 智能体的工作流,将 AI 智能体执行任务的过程抽象为一个由节点(Node)和边 (Edge)构成的有向循环图(Directed Cyclic Graph,DCG)。这种状态图结构不仅 赋予了 LangGraph 框架极大的灵活性,更使其能够有效地构建状态化(Stateful)和 多智能体(Multi-agent)的复杂 AI 应用,从而应对传统框架难以企及的挑战。

下图展示了 LangGraph 核心架构,它由节点(Node)、边(Edge)和状态(State) 组成。节点代表工作流中的计算单元,边定义节点之间的流向,状态则用于在节点之间传递和共享信息。

![image-20251027212328127]()